在數據驅動的時代,有效開展數據分析已成為企業決策、科學研究和社會洞察的核心能力。數據分析并非始于炫酷的圖表或復雜的模型,而是始于最基礎也最關鍵的環節——數據處理技術。它如同大廈的地基,決定了后續所有分析的準確性、可靠性與效率。掌握扎實的數據處理技術,是每一位數據分析師邁向成功的第一步。

一、 數據處理:數據分析的生命線

數據處理是指對原始數據進行清洗、轉換、集成和規整,使其成為適合分析的結構化、高質量數據集的過程。未經處理的原始數據往往存在缺失、錯誤、不一致、重復、格式混亂等問題,直接進行分析不僅可能導致錯誤結論,更會浪費大量計算資源。因此,數據處理是確保分析結果可信、行動決策有效的生命線。

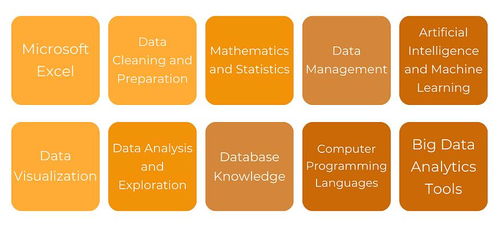

二、 有效開展數據分析所需的關鍵數據處理技能

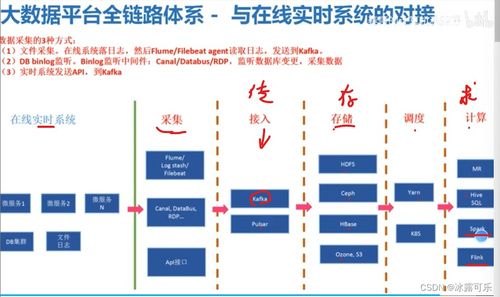

1. 數據獲取與連接能力:

數據分析的第一步是獲取數據。這要求分析師能夠熟練地從多種源頭(如數據庫、API接口、日志文件、Excel/CSV文件、網頁爬蟲等)提取數據。掌握SQL語言是關系型數據庫查詢的必備技能,同時了解如何使用Python的pandas、requests庫或R語言的dplyr、httr包進行數據連接與整合也至關重要。

2. 數據清洗與質量評估:

這是數據處理中最耗時但也最體現價值的環節。核心技能包括:

- 缺失值處理:能夠判斷缺失機制,并合理選擇刪除、填充(均值、中位數、插值、預測模型填充)等策略。

- 異常值檢測與處理:運用統計方法(如3σ原則、箱線圖)或業務規則識別異常值,并決定是修正、保留還是剔除。

- 數據一致性校驗:解決格式不一致(如日期格式)、單位不統一、邏輯矛盾(如年齡為負數)等問題。

- 重復值識別與去重:準確識別并處理重復記錄。

3. 數據轉換與特征工程:

將原始數據轉化為更適合模型理解的特征。技能包括:

- 數據規范化/標準化:消除量綱影響,如最小-最大歸一化、Z-score標準化。

- 類型轉換:數值與分類變量之間的轉換,創建虛擬變量。

- 特征構造:基于業務知識,從現有字段中衍生出更有意義的新特征(如從日期中提取周次、季節;從地址中提取城市)。

- 數據聚合與重塑:使用數據透視或分組聚合(如

GROUP BY)來匯總數據。

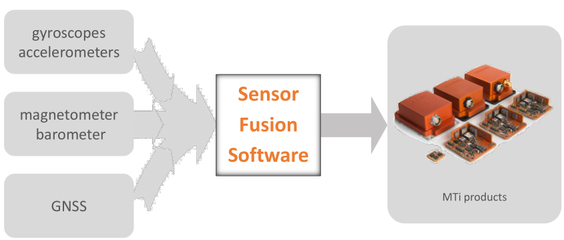

4. 數據集成與融合:

當數據來自多個異構來源時,需要將其整合到一起。這需要掌握主鍵匹配、表連接(JOIN)、數據融合等技術,并能夠處理實體解析問題(如不同系統中同一客戶的標識符不同)。

- 熟練使用數據處理工具與編程語言:

- SQL:用于大規模數據提取、清洗和聚合的行業標準。

- Python:憑借

pandas、NumPy庫,在數據清洗、轉換方面功能強大且靈活。pandas提供了DataFrame這一高效數據結構,是處理表格數據的利器。

- R語言:

dplyr、tidyr、data.table等包提供了優雅且高效的數據處理語法。

- 可視化工具輔助:如利用Tableau Prep、Power Query進行初步的可視化數據清洗,尤其適合業務分析師。

6. 自動化與流程化思維:

優秀的數據分析師不會滿足于一次性處理。他們善于編寫可復用的腳本,將數據處理流程自動化、管道化(例如使用Python函數或Airflow等調度工具)。這不僅能提高效率,更能確保處理過程的一致性和可追溯性。

7. 深刻的業務理解與數據敏感度:

這是所有技術技能的“靈魂”。知道如何處理數據,很大程度上取決于你理解這些數據在業務上下文中的含義。一個異常值可能是數據錯誤,也可能是一個極具價值的商業機會信號。這種判斷力需要業務知識與數據經驗的長期積累。

三、 實踐建議:構建堅實的數據處理能力

- 從項目實戰中學習:理論結合實踐是最好的方法。尋找公開數據集或工作中的實際數據,從頭到尾完成一個完整的數據處理流程。

- 精通一到兩種核心工具:深度優先于廣度。首先熟練掌握SQL和Python(或R)中的一套,建立核心競爭力。

- 關注數據質量文檔:在處理過程中,養成記錄數據字典、清洗規則、假設和遇到問題的習慣,這有助于團隊協作和結果審計。

- 擁抱迭代:數據處理很少能一步到位。通常需要根據初步分析結果,回頭調整數據處理步驟,這是一個迭代優化的過程。

###

數據處理技術或許不像機器學習模型那樣光鮮,但它是一切高級分析的基礎。它考驗的是分析師的耐心、嚴謹和邏輯性。一個擁有卓越數據處理能力的數據分析師,能夠從混沌中建立秩序,從噪聲中提取信號,為后續的探索性分析、統計建模和商業智能報告提供堅實、清潔的“燃料”。投資于這項關鍵技能,就是投資于數據分析工作本身的價值與可信度。